Comment avez-vous commencé votre carrière au CNES ?

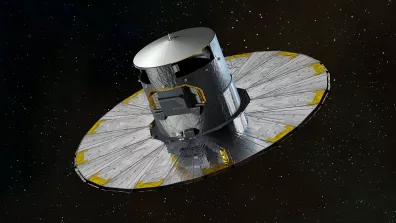

« Je suis arrivé au CNES sur un poste de traitement des images du satellite SPOT en 1986. J’assurais la maintenance de tout le système. C’était relativement moderne, une dizaine de machines « Solar » composaient le centre de traitement. J’avais échappé de peu aux cartes magnétiques, celles qu’on voit dans les films ! »

Au début, on n’avait pas vraiment la technologie suffisante pour faire nos missions spatiales. On essayait juste de recevoir et traiter les données sans perte. On stockait les données de télémesure sur des grosses bandes magnétiques, on n’avait quasiment pas d’écran pour visualiser les images qu’il fallait donc imprimer sur des tirages photographiques ! A vrai dire, formé en tant qu’ingénieur « optique et traitement du signal », je ne m’y connaissais pas trop en informatique. J’avais tout à découvrir.

FV : De mon côté, je suis entré au CNES en 2019 en tant qu’ingénieur calcul haute performance et traitement de la donnée. Avant cela, j’ai fait un doctorat en mathématiques, que j’ai réalisé chez Total en partenariat avec INRIA et l’Université de Pau et des Pays de l’Adour. Total est le seul industriel français à disposer d’un des plus gros supercalculateurs au monde !

L’informatique et les mathématiques font partie de mon quotidien aussi bien pour dimensionner les moyens de calculs et de stockage mais également pour permettre le passage à grande échelle des codes de calculs.

« Sans ce merveilleux outil qu’est l’informatique et en particulier notre supercalculateur, nous ne pourrions pas traiter de manière efficace et dans un temps raisonnable toutes les données que nous récupérons des satellites. »

En 40 ans, quel a été le plus gros changement ?

JPG : Le plus incroyable, c’est que l’informatique est née avec moi dans les années 1960. En 1986, on était encore sur des systèmes très spécifiques. Les plus gros disques durs avaient la taille d’une machine à laver et une capacité de 300 Mo ! Depuis les années 1980, il y a eu 2 grosses révolutions : la puissance des machines a été multipliée par 1 million ! Des machines qui tournaient à 0,2 Mflops tournent aujourd’hui à 400 Mflops !

La 2e révolution porte sur les réseaux : La puissance du « transport » de l’information a elle aussi été multipliée par 1 million, avec une accélération incroyable quand internet s’est développé dans les années 90.

Ce sont ces 2 facteurs qui ont permis l’hypernumérisation dans laquelle on vit aujourd’hui et dans laquelle sont nés les digital natives... dont Florent fait partie !

FV : C’est vrai que de mon côté, je vis toutes les évolutions de ces dernières années comme une continuité. Au-delà de l’amélioration naturelle de la puissance, du débit ou des capacités de stockage – les serveurs ont la même taille qu’avant mais leurs capacités ne sont pas du tout les mêmes grâce à la miniaturisation ! - on repousse aussi les limites technologiques en croisant les sources de données. Cela n’est possible que parce qu’on peut facilement échanger les données et faire du traitement massif, notamment grâce aux performances des moyens de stockage et des réseaux de communication.

C'est quoi le traitement de l'information ?

Le traitement des données est ainsi un challenge de taille, afin de transformer la mesure brute (télémesure) en information.

« La donnée en elle-même n'est rien sans le traitement. Il s'agit de la brique de base qui va venir ensuite alimenter des modèles, des simulations. » précise Jean-Pierre Gleyzes.

Traiter la donnée, cela signifie décoder, extraire et reconstituer les mesures scientifiques (que ce soit une image, un spectre, un champ magnétique…), les dater de façon précise, et les transformer en valeurs physiques interprétables et visualisables, afin de pouvoir les intégrer ensuite dans des modèles scientifiques (océanographique, météorologique, climatique, etc).

Quelles pourraient être les futures révolutions de la gestion des données ?

FV : Pour moi, la grosse révolution à venir au niveau du calcul pour le traitement de la donnée c’est le quantique. Ce domaine commence à quitter le monde de la recherche pour le monde industriel et cela va complètement rabattre les cartes de l’informatique au niveau mondial. Grâce au quantique, tout deviendra possible, tout sera « craquable » en un temps record. La question de la cybersécurité est au cœur du sujet.

Il y a aussi la question de l’intelligence artificielle…

JPG : Le développement de l’IA a commencé dans les années 1992-1993 au CNES, avec des modèles entrainés pour détecter les nuages dans les images SPOT. Mais c’était quelque chose de très complexe et avec des taux d’erreur élevés. Aujourd’hui, c’est beaucoup plus efficace car la phase d’apprentissage des modèles a été grandement automatisée. L’IA peut être utilisée pour faire des choses trop « pénibles ou répétitives » pour les êtres humains, en allant chercher des données spécifiques dans des archives gigantesques (le big data !). Par exemple au CNES, cela nous sert à faire de la maintenance prédictive sur nos satellites : l’IA va détecter les signaux faibles que l’opérateur ne voit pas et ainsi cibler sur des défauts potentiels à surveiller par nos ingénieurs.

Quels sont les enjeux technologiques de la gestion et du traitement des données aujourd’hui ?

FV : Au niveau technologique, les enjeux actuels dans la gestion du traitement des données sont de différentes natures et variées. On peut évoquer par exemple la question du langage de programmation et de son efficacité dans le traitement des données. Avant pour chaque nouveau besoin, nous recodions tout. Aujourd’hui, de plus en plus de personnes utilisent directement un empilement de bouts de codes récupérés sur le net ! Mais plus on empile les couches logicielles, plus on perd le contrôle à la fois sur le fonctionnement mais également sur la consommation en ressources. Cette perte de maitrise à un impact direct sur l’efficacité de calcul, sur la faisabilité mais également sur la consommation électrique.

En optimisant, on peut pourtant réduire les temps d’exécution d’un facteur 2, 10 voire 100 dans les cas les plus adaptés. En terme de consommation de mémoire là aussi, les marges de manœuvres sont importantes afin d’en limiter sa consommation excessive : c’est un enjeu pour à la fois maximiser l’utilisation des calculateurs (et traiter plus, plus rapidement) mais surtout en termes écologiques car les ressources utilisées sont parfois énormes.

JPG : Cet aspect écologique est de plus en plus prégnant. Les machines sont aujourd’hui plus puissantes et plus performantes mais logiquement elles sont donc plus gourmandes en énergie. La consommation électrique d’un centre de calcul comme celui du CNES s’apparente à celle d’un village ! Cette question de la frugalité numérique devient un critère important. Par exemple, au CNES, nous allons changer de génération de cluster et nous avons un volet dédié sur l’efficacité énergétique.

Et les enjeux scientifiques ?

JPG : On parlait du croisement des données. C’est justement en croisant des données que l’on peut avoir des informations scientifiques supplémentaires.

Grâce au traitement des données, on peut aussi réaliser de longues séries temporelles, en retraitant d’anciennes données et en les rendant « compatibles en continuité » avec les données des nouvelles générations de capteurs.

Il y a également la question de l’extraction, c’est-à-dire d’aller chercher dans les centaines de Pétabytes de nos archives, les données dont on a besoin sur une situation spécifique - comme lors d’une crise humanitaire ou économique par exemple – et d’être capable d'être extrêmement réactif sur la correction, le traitement et la diffusion de ces données.

FV : Dans le monde scientifique, l’ouverture est également un enjeu de taille pour être en mesure de croiser les données récoltées par les uns et les autres dans le monde entier mais également pouvoir les traiter à l’endroit où elles sont.

Au-delà de la préservation des données, c’est les rendre accessible, pouvoir les coupler. Cette dimension d’intéropérabilité des données scientifiques est fondamentale. Cela signifie produire des formats standards utilisables par tous : une série de données est par exemple inutilisable si on ne précise pas par quel instrument et dans quelles conditions elles ont été récoltées. Elles ne servent à rien également si on les propose dans un format que personne ne peut lire.

Cette ouverture est-elle sans danger ?

JPG : Le paradoxe, c’est qu’il faut être aussi ouvert que possible et aussi fermé que nécessaire !

La démarche d’ouverture bénéficie au monde scientifique mais aussi au monde industriel. Nos 30 ans de patrimoine en données spatiales peuvent intéresser tout le monde des laboratoires aux PME, en passant par les villes. Il faut mettre en place une simplicité d’accès à nos services. Mais même si c’est ouvert, il ne faut pas être naïf : nous devons protéger notre patrimoine contre les cyber attaques externes voire le sabotage. L’équipe de cybersécurité s’est créée au CNES en même temps qu’internet et n’a cessé de grandir depuis.

FV : Ajouter de nouvelles technologies, c’est prendre le risque qu’elles engendrent de nouvelles failles de sécurité. La cybersécurité, c’est une lutte incessante !

Il y a enfin des enjeux politiques...

JPG : L’ouverture pose évidemment des questions en termes de contrôle. Par exemple, la NASA nous impose de travailler sur le Cloud d’Amazon pour le projet SWOT. C’est une solution techniquement très bonne mais qui repose la question de la souveraineté. Les GAFA disposent de gros moyens pour stocker et traiter les données mais qu’en font-ils après ? L’étape suivante pour nous serait de disposer d’un cloud souverain national ou européen.

FV : Et au-delà de la souveraineté, gardons en tête qu’il est important d’utiliser toutes les technologies possibles, de se diversifier pour pérenniser nos moyens de calculs mais également nos données. Le Cloud est une solution, mais n’est en aucun cas LA solution. Nous devons nous adapter en permanence et proposer aux projets les moyens les plus appropriés !